해시계의 원리와 컴퓨터 비전 응용 #2

Computer vision applications and the principle of the sundial #2

- 해시계(Sundial) - 해시계의 원리와 컴퓨터 비전 응용 #1

- 컴퓨터 비전 응용

해시계는 태양의 위치(혹은 태양의 위치로부터 얻어진 그림자)를 통해 시간을 측정하는 장치 입니다. 그러면 거꾸로 시간으로부터 태양의 위치를 혹은 지구상의 위치를 결정할 수 있지 않을까요?

해시계의 원리를 분석해 보면 답이 보입니다. 시간을 알기 위해서는 지구상의 위치를 알아야만 합니다. 적도에서 태양의 위치와 극지방에서 태양의 위치는 같은 시간에도 완전히 다르기 때문입니다. 시간을 알기 위해서 알아야 하는 요소는

- 위도, 경도

- 진북 방향

입니다.

'앙부일구'로 시간을 측정할 때 진북 방향으로 향하게 두고, 그림자의 방향과 길이를 보면 절기와 시간을 알 수 있습니다. 우리나라의 서울은 자북과 진북의 차이, 자편각이 서쪽으로 약 7.57도 발생하니 이것을 보정해주고, 동경(도쿄)과 같은 시간대를 사용하는 GMT+9이므로 실제 서울의 동경 127도 보다 빠른 시간대를 사용하기 때문에 이것까지 보정해주면 태양시를 우리가 현재 사용하는 시간으로 구할 수 있습니다.

그러면 거꾸로 시간이 주어지면 어떨까요?

- 날짜, 시간

- 진북 방향

이 주어지면 위도, 경도를 알 수 있지 않을까요? 세상은 참 넓고 사람은 많습니다. 그런 생각을 한 사람이 있었습니다.

Junejo, Imran N., and Hassan Foroosh. "GPS coordinates estimation and camera calibration from solar shadows." Computer Vision and Image Understanding 114.9 (2010): 991-1003.

인기 있는 연구 분야는 아니어서 인용은 많이 되지 않았지만 생각을 실제로 구현한 것은 충분히 훌륭한 일이라고 생각합니다.

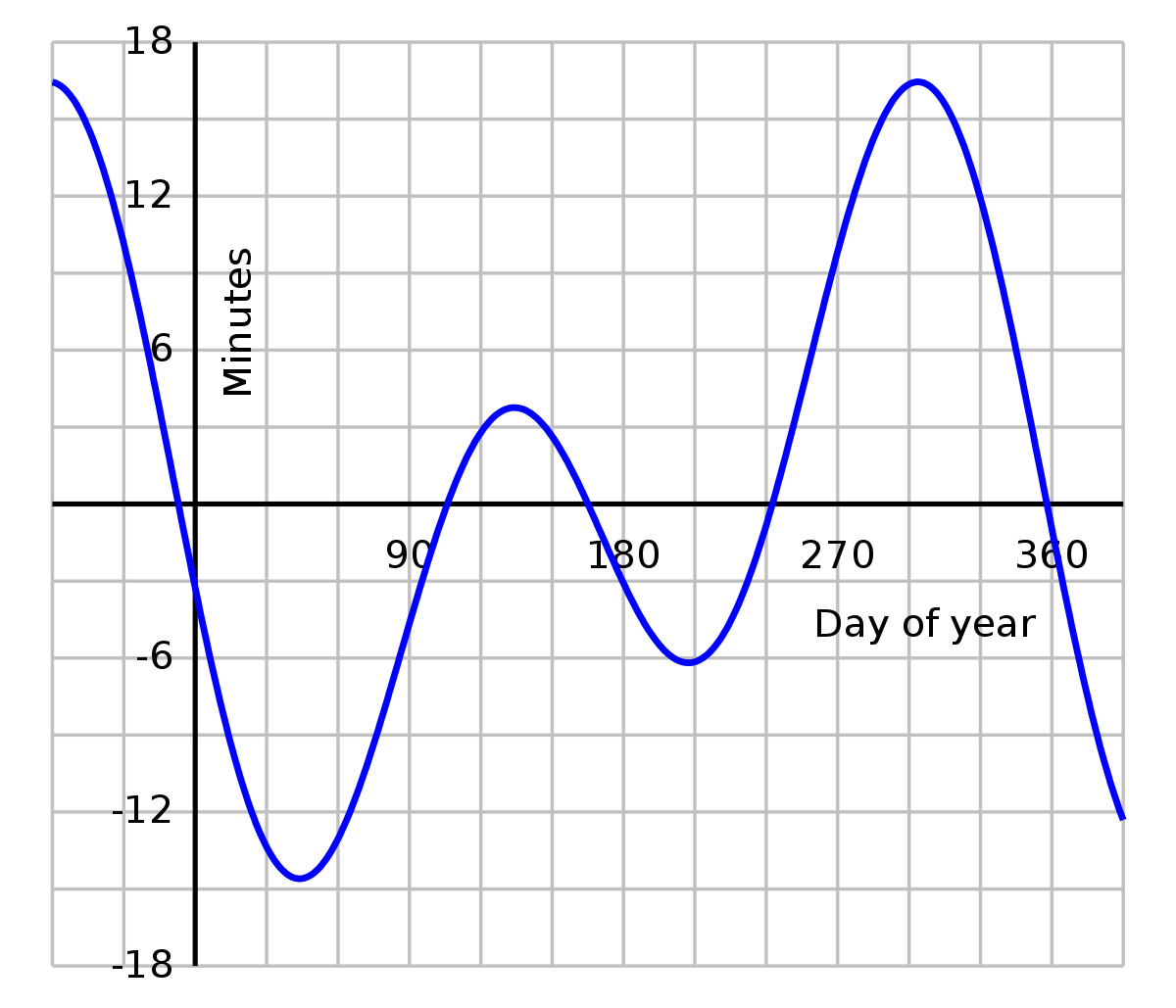

두 개의 지면에서 수직한 물체기 있는 경우 두 물체가 그리는 포물선의 중심을 연장한 지점이 만나는 곳이 정남향이 됩니다. 현재 그림자의 위치와 물체의 끝점을 연장한 곳에는 태양이 있을 겁니다. 기존의 방대한 데이터로부터 우리는 어떤 시점에 태양이 위치해야 하는 곳을 알고 있기 때문에 그것에서 위치를 결정할 수 있습니다. 년중 단 두 번의 모호함이 있는데 춘분과 추분입니다. 태양의 8자 궤도가 만나는 점입니다.

해시계의 원리를 분석해 보면 답이 보입니다. 시간을 알기 위해서는 지구상의 위치를 알아야만 합니다. 적도에서 태양의 위치와 극지방에서 태양의 위치는 같은 시간에도 완전히 다르기 때문입니다. 시간을 알기 위해서 알아야 하는 요소는

- 위도, 경도

- 진북 방향

입니다.

'앙부일구'로 시간을 측정할 때 진북 방향으로 향하게 두고, 그림자의 방향과 길이를 보면 절기와 시간을 알 수 있습니다. 우리나라의 서울은 자북과 진북의 차이, 자편각이 서쪽으로 약 7.57도 발생하니 이것을 보정해주고, 동경(도쿄)과 같은 시간대를 사용하는 GMT+9이므로 실제 서울의 동경 127도 보다 빠른 시간대를 사용하기 때문에 이것까지 보정해주면 태양시를 우리가 현재 사용하는 시간으로 구할 수 있습니다.

그러면 거꾸로 시간이 주어지면 어떨까요?

- 날짜, 시간

- 진북 방향

이 주어지면 위도, 경도를 알 수 있지 않을까요? 세상은 참 넓고 사람은 많습니다. 그런 생각을 한 사람이 있었습니다.

|

| Junejo, Imran N., and Hassan Foroosh. "GPS coordinates estimation and camera calibration from solar shadows." Computer Vision and Image Understanding 114.9 (2010): 991-1003. |

두 개의 지면에서 수직한 물체기 있는 경우 두 물체가 그리는 포물선의 중심을 연장한 지점이 만나는 곳이 정남향이 됩니다. 현재 그림자의 위치와 물체의 끝점을 연장한 곳에는 태양이 있을 겁니다. 기존의 방대한 데이터로부터 우리는 어떤 시점에 태양이 위치해야 하는 곳을 알고 있기 때문에 그것에서 위치를 결정할 수 있습니다. 년중 단 두 번의 모호함이 있는데 춘분과 추분입니다. 태양의 8자 궤도가 만나는 점입니다.